TL;DR

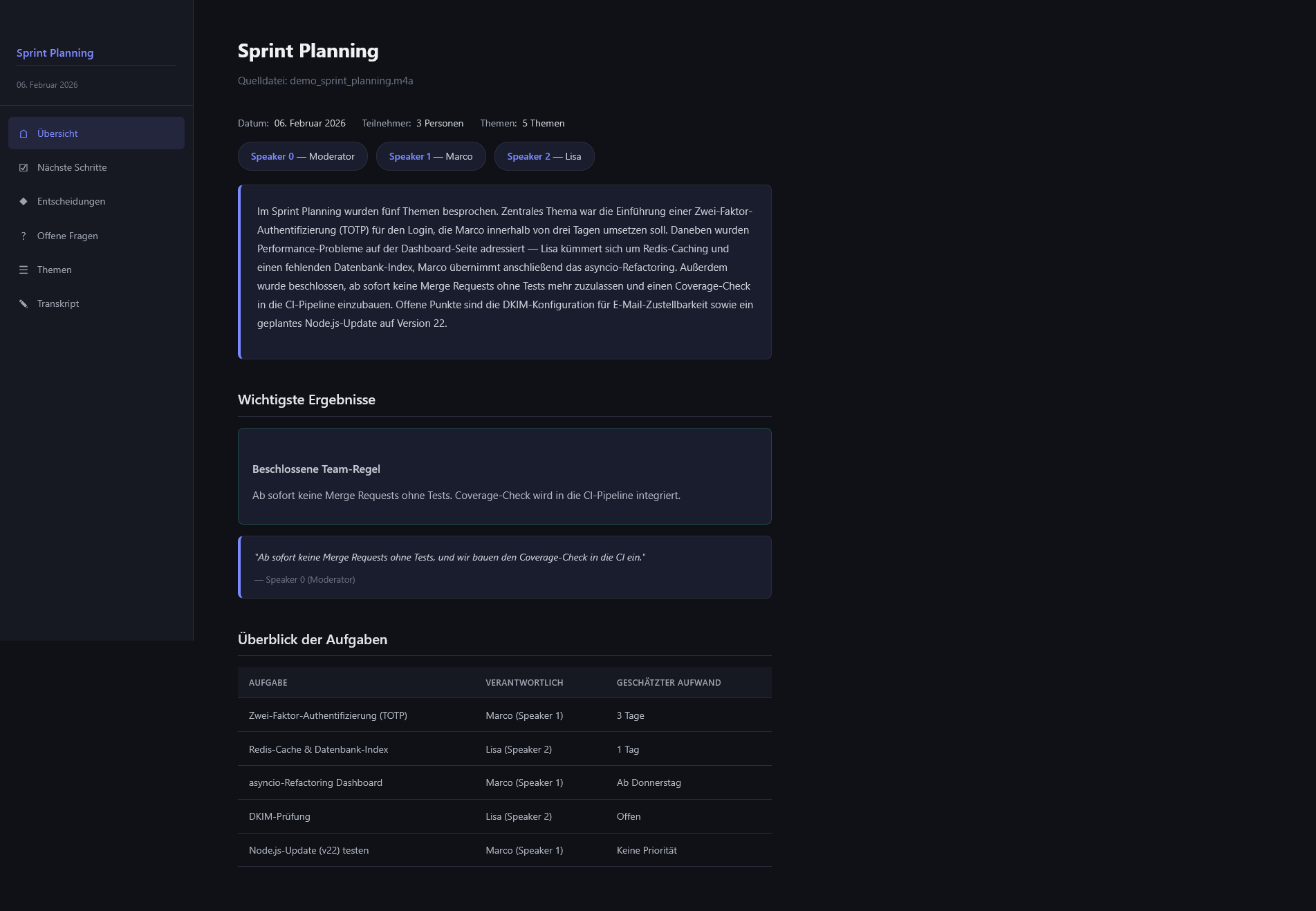

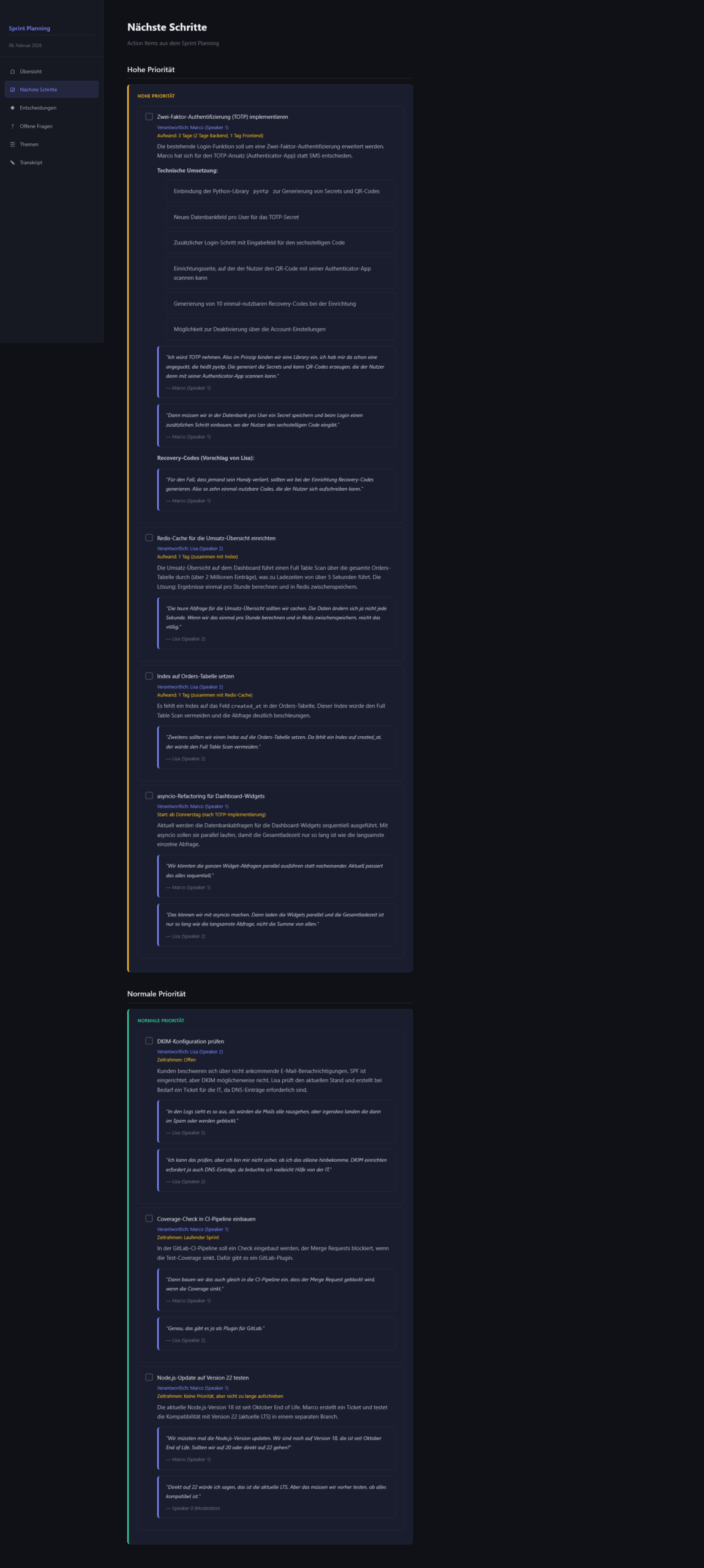

Ich habe ein praktisches Tool gebaut, das Meeting‑Aufnahmen automatisch transkribiert, von einem LLM auswerten lässt und daraus eine klar gegliederte HTML‑Dokumentation erzeugt. Die Struktur passt sich dem tatsächlichen Gespräch an, statt ein starres Template zu erzwingen: mit Fokus auf Next Steps und Verantwortlichkeiten. Die Transkription übernimmt ein Speech‑to‑Text‑Dienst mit Sprecher‑Erkennung; die Auswertung und HTML‑Erstellung läuft über ein LLM. Ergebnis: schnellere Nachbereitung, weniger Informationsverluste, klarere Umsetzung.

Kontext & Ziel

Diese Woche habe ich eine kurze Pause vom größeren Context‑Tracker gemacht und ein kleines, in sich geschlossenes Projekt eingeschoben. Ausgangspunkt war eine simple Beobachtung: In vielen Teams werden Meetings zwar aufgezeichnet und geteilt, aber danach „passiert“ wenig mit dem Material. Dabei steckt in jeder Sitzung viel Wissen – vor allem das, was als Nächstes getan werden soll. Mein Ziel war ein schlanker Ablauf, der Audio‑ oder Video‑Dateien einliest, zuverlässig transkribiert und daraus eine HTML‑Struktur erzeugt, die genau das abbildet, was im Meeting wirklich wichtig war. Entscheidend: keine starre Menü‑Navigation, sondern eine adaptive Gliederung, die den Gesprächsverlauf und die Prioritäten widerspiegelt. So soll jede Sitzung nicht nur archiviert, sondern in umsetzbare Arbeit überführt werden.

Meine Anforderungen

Als Nutzerin möchte ich Meeting‑Aufnahmen ohne manuellen Aufwand in lesbare, nachvollziehbare Dokumente verwandeln

Ich will eine klare Übersicht der nächsten Schritte und Verantwortlichkeiten, nicht nur Textchaos

Die HTML‑Struktur soll sich dem Meeting anpassen und nicht jedes Mal gleich aussehen

Ich brauche eine saubere Sprecher‑Erkennung, damit Aussagen zugeordnet bleiben

Ich will keine komplizierte Bedienung, sondern einen einfachen, reproduzierbaren Ablauf

Mein AI-Workflow

NEU: Aktuell spare ich bei der Entwicklung Zeit, in dem ich meine Anweisungen per Sprachsteuerung (Wispr Flow) eingebe, statt zu tippen. Ich habe mich jahrelang gegen Sprachsteuerung im Alltag gewehrt, weil ich geräuschempfindlich bin, aber ich habe in 12 Tagen bereits 43k Wörter eingesprochen. Ich bin also offiziell bekehrt.

Ich habe das Tool mit Claude Code geplant und dabei eine HTML-Dokumentation erstellen lassen, die während der Planung laufend aktualisiert wurde. In der Dokumentation wurden alle wichtigen Details für die Umsetzung, die Anforderungen und offene Fragen festgehalten. Ich habe Claude Code dabei aufgetragen, mir regelmäßig Fragen zu stellen, damit die Dokumentation so vollständig wie möglich wird. Ziel war es, dass die Dokumentation so vollständig ist, dass ein LLM basierend auf den Dateien erfolgreich entwickeln kann, ohne viel raten zu müssen.

Für die Gestaltung des Blogbildes kam wieder ChatGPT zum Einsatz.

Das Tool selber nutzt im Hintergrund auch Claude Code.

Was die Pipeline kann

👉 Sie nimmt Meeting‑Audio in Google Drive entgegen, transkribiert es inkl. Sprecher‑Erkennung und bereitet das Ergebnis als lesbare HTML‑Seiten auf

👉 Die inhaltliche Struktur passt sich dem Gespräch an: Themenblöcke, Kernaussagen, Entscheidungen und vor allem Nächste Schritte

👉 Pro Meeting entsteht ein Ordner mit Übersichtsseite, optionalen Unterseiten und einem ansprechenden Dark‑Theme‑Stylesheet

👉 Der Fokus liegt auf Umsetzbarkeit: Am Ende weiß man, wer was bis wann macht – ohne langes Scrollen durch Roh‑Transkripte

Stack & Tools

Backend: Python

AI: Claude (LLM‑Auswertung), ChatGPT (Bildgestaltung)

Speech‑to‑Text: Deepgram (Transkription mit Sprecher‑Erkennung)

Utilities: FFmpeg (Audio‑Konvertierung)

Ablage & Output: Eingehende Dateien aus einem Drive‑Ordner, Ergebnis als HTML/CSS‑Struktur

Herausforderungen & Learnings

Verlässliche Transkription mit Sprecher‑Erkennung: Kostenlos kaum zu finden; Deepgram funktioniert gut, ist aber ab einem Volumen kostenpflichtig

Prompt‑Design für adaptive HTML: Struktur soll sich nach Inhalt richten, nicht umgekehrt. Da war Feintuning nötig

Datenschutz in der Darstellung: Für Screenshots verwende ich ein künstliches Demo‑Transkript, das Tool wurde aber mit echten Daten erfolgreich getestet

Planung in HTML statt Chat‑Scrollen: Die Methode macht Entwicklung leichter und spürbar schneller, weil Entscheidungen und offene Fragen sauber nachverfolgbar sind

Keine Live-Demo

Das Tool läuft lokal, also keine Demo.

Außerdem ist das Tool „nur“ ein Python-Skript ohne UI.

Fazit

Woche 24: ✅

Die Meeting Pipeline hat spürbaren Nutzen: Aus rohem Audio wird eine verständliche, handlungsorientierte Dokumentation, die sich am tatsächlichen Gespräch orientiert. Die Kombination aus zuverlässiger Transkription und LLM‑basierter Strukturierung sorgt dafür, dass Entscheidungen, To‑dos und Verantwortlichkeiten im Vordergrund stehen; genau das, was nach einem Meeting zählt. Gleichzeitig hat sich erneut gezeigt, wie wertvoll es ist, die Planung selbst in HTML festzuhalten: weniger Kontext‑Verlust, weniger Hin‑und‑Her, mehr Klarheit. Für mich ist das eine praktikable Methode, die ich künftig standardmäßig einsetzen werde.